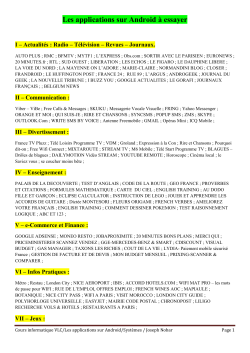

n°32, automne 2014 - La revue européenne des médias et du