àîéãú ôøîèøéí - Stanford AI Lab

29

פרק ב

הסקה סטטיסטית

2.1על בעיית ההסקה הסטטיסטית

הסקה סטטיסטית ) (statistical inferenceמטפלת במצב בו יש לנו נתונים שנוצרו

מתוך התפלגות שאינה ידועה לנו ,ועלינו לנתח אותם ולהסיק מסקנות לגביהם

ולגבי ההתפלגות שיצרה אותם .במילים אחרות ,ברבות מהבעיות הסטטיסטיות

בהן נדון ,קיימות כמה התפלגויות אפשריות שיצרו נתונים מסוימים )ובבעיות

אמיתיות ,מספר אינסופי של התפלגויות אפשריות כאלו( ,ואנחנו מנסים ללמוד על

ההתפלגויות האלו ,להסיק על תכונות מסוימות שלהן ,ולקבוע את הסבירות שכל

אחת מההתפלגויות האלו היא זו שיצרה את הנתונים בפועל.

בפרק הנוכחי נתאר את הגישה הבייסיאנית להסקה סטטיסטית .כדי להבהיר את

המושגים הבסיסיים ,נתמקד במקרה הפשוט בו יש מספר קטן של התפלגויות

אפשריות שיצרו את הנתונים.

2.2הסקה והכרעה בייסיאנית

תורת ההסקה הבייסיאנית היא גישה סטטיסטית לקבלת החלטות בתנאי אי ודאות.

גישה זו מבוססת על ההנחה כי הידע הרלבנטי להחלטה מבוטא בצורה

הסתברותית וכי כל ההסתברויות הרלוונטיות ידועות .המודל הפורמלי להכרעה

בייסיאנית מבוסס על חמישה מרכיבים שיתוארו להלן.

2.2.1תמונת העולם בגישה הבייסיאנית

הדוגמא הקאנונית המשמשת לתיאור תמונת העולם הבייסיאנית ,היא אדם היוצא

מהבית ביום חורפי ומתלבט האם לקחת עמו מטריה .נניח לשם הפשטות כי

קיימות מבחינתו שתי אפשרויות בלבד :יהיה יום גשום או לא .מצד אחד הוא חושש

להרטב אם לא ייקח מטריה ויהיה גשום ,ומצד שני אם ייקח מטריה ביום ללא גשם,

ייסחב אתה שלא לצורך .האדם מציץ מהחלון ורואה עננים שחורים וכבדים ,ולכן

מחליט שהסיכון לגשם גובר ,ומחליט לקחת מטריה .תיאור פורמלי של הבעיה

במונחים בייסיאנים מתבסס על המרכיבים הבאים:

30

קבוצת מצבי העולם האפשריים }Ω={ωi

"מצבי העולם" מוגדרים כך שידיעת מצב העולם מספקת לנו מידע

הסתברותי מקסימלי :ידועות לנו ההתפלגויות שיצרו את התצפיות .מצבי

העולם השונים הם זרים ωi ∩ ω j = φוממצים . ∪ω j = Ω

תצפיות }X={x1,…,xn

אלו הם הנתונים שיש בידינו ומהם אנחנו מנסים להסיק מהו מצב העולם.

בדרך כלל לא נוכל להסיק בוודאות מתוך התבוננות בתצפיות מהו מצב

העולם.

מודל הסתברותי של העולם })P={P0(ωi),P(X|ωi

על פי הגישה הבייסיאנית אנו מניחים כי יש לנו ידע הסתברותי מפורש על

העולם .ידע זה כולל הסתברויות א-פריוריות ) P0(ωiעל הסיכוי להמצא

במצב עולם ,ωiוהסתברויות מותנות לערכי התצפיות Xבהינתן מצב

עולם נתון ).P(xj|ωi

פעולות אפשריות }A={α1,…,αk

קבוצת הפעולות מביניהן עלינו לבחור .לכל פעולה נקבע מחיר )ראה

הפריט הבא( התלוי במצב העולם ,ונשאף כמובן לבחור בפעולה

המתאימה ביותר למצב העולם.

מחיר לכל פעולה })Λ={λ(αk,ωi

לתוצאות של הפעולות שלנו יש ,כידוע ,מחיר ,וזה נקבע על פי מצב

העולם .פעולה שאינה מתאימה למצב העולם בו אנחנו נמצאים תלווה

בדרך כלל בקנס )מחיר בעל ערך חיובי( ,ופעולה מתאימה תלווה ברווח

עבורנו )מחיר אי שלילי( .המחיר של פעולה αkבמצב עולם ωiיסומן ב-

) ,λ(αk|ωiואת מטריצת המחירים נסמן ב. Λ={λ(αk|ωi)} -

בדוגמת המטריה שתיארנו קודם ,הרי שישנם שני מצבי עולם אפשריים )יש או אין

גשם( ,ונניח כי שכיחותם של ימי הגשם בחורף ידועה .ישנן גם שתי פעולות

אפשריות )לקחת מטריה או לא( ,ולשתיהן מחירים שונים כתלות בשאלה האם ירד

גשם או לא .התצפית )ענני גשם( משנה את ההערכה על ההסתברות שגשם אכן

ירד ,ומשפיעה על ההחלטה לקחת מטריה.

הגישה הבייסיאנית לקבלת החלטות דורשת שיהיו בידיכם הן ההסתברות

האפריוריות )שכיחות ימי הגשם( ,והן ההסתברויות המותנות )מה ההסתברות

לעננות כבדה ביום גשום( .למרות שמידע כזה אינו ידוע בדרך כלל במפורש לכל

אדם ,הרי שאין מניעה עקרונית לאסוף אותו ,כך שהאזרח התמים יוכל לשמור על

בגדיו יבשים במינימום מאמץ.

31

נפנה כעת לדון באסטרטגיה הנכונה לקבלת החלטות בגישה הבייסיאנית.

2.2.2הכרעה בייסיאנית

בהינתן בעיית ההכרעה הבייסיאנית } ,{Ω,X,P,A,Λנרצה לבחור את הפעולה

האופטימלית שכדאי לנקוט אם אנו רואים תצפית .xjלצורך כך ,ננסה כעת להגדיר

פונקצית החלטה דטרמיניסטית α : X → Aהמתאימה לכל תצפית x jפעולה

אופטימלית . α kעד כה הגדרנו מחיר לפעולות בהינתן מצב העולם ,אך מה שנתון

לנו בפועל הן התצפיות ולכן עלינו לשקלל את מחירי הפעולות בהתאם

להסתברויות של מצבי העולם השונים ,כפי שהן מושפעות מהתצפיות שברשותנו.

הסיכון המותנה

כדי למצוא פונקצית החלטה דטרמיניסטית אופטימלית נגדיר את הסיכון המותנה

) (Conditional Riskלביצוע פעולה α kבהינתן שראינו תצפית x j

| ωi )P (ω i | x j ) ,

k

∑ λ (α

ωi ∈Ω

≡ ) R (α k | x j

)(2.1

ואת ההסתברות האפוסטריורית להימצא במצב עולם ωiנחשב תוך שימוש

בנוסחת בייס )סעיף (1.2.2

) P0 (ωi

) P( x j | ωi

) | ωt ) P0 (ωt

j

P( x

∑

ω

= ) P0 (ωi

) P ( x j | ωi

) P( x j

= ) P (ωi | x j

t

הסיכון הכולל

בהינתן אסטרטגיית הכרעה הקובעת באיזו פעולה ננקוט עבור כל תצפית ,ניתן

לחשב את הסיכון הכולל של שימוש בפונקציה כזו .הסיכון הכולל הוא ממוצע

הסיכונים על פני התצפיות האפשריות:

)(2.2

) R [α ( x )] ≡ ∑ R (α ( x j ) | x j ) P ( x j

j

ובמקרה הרציף

R [α ( x )] ≡ ∫ R(α ( x j ) | x j ) P ( x j )dx

X

32

משפט :פונקצית ההכרעה האופטימלית

פונקצית ההכרעה ) α*(xהמביאה למינימום את הסיכון הכולל תהיה הפונקציה

המביאה למינימום את הסיכון המותנה לכל תצפית אפשרית .במלים אחרות,

פונקצית ההכרעה האופטימלית קובעת לכל תצפית xאת הפעולה בעלת הסיכון

המותנה הקטן ביותר .ובאופן פורמלי :בהינתן xהכרע * αאם לכל * α'≠αמתקיים

).R(α*|x)≤R(α'|x

הוכחה

לכל

*α'≠α

ולכל

) , R (α *| x ) ≤ R (α ' | x

מתקיים

x

) ∑ R (α * ( x ) | x ) P ( x ) ≤ ∑ R (α '( x ) | x ) P ( x

i

i

i

i

i

i

i

i

ולכן

מתקיים

ולכן ] )R [α * ( x) ] ≤ R [α '( x

כנדרש.

פונקצית δכפונקצית מחיר

הסיכון מקבל משמעות פשוטה כאשר פונקצית המחיר מקבלת ערך אפס אם בחרנו

נכונה וערך 1אם שגינו . λ (α k | ωi ) = 1 − δ kiעם פונקצית המחיר הזו ,אנחנו

משלמים מחיר רק אם טעינו ,ולכן הסיכון המותנה הוא פשוט הסיכוי לטעות

) R (α k | x j ) = ∑ (1 − δ ki ) P (ωi | x j ) = ∑ P (ωi | x j

i≠k

i

והסיכון הכולל יהיה הסיכוי הכולל לטעות )עבור כל התצפיות האפשריות( .כלל

ההכרעה האופטימלי במקרה זה גם הוא פשוט -

"בחר את מצב העולם הסביר ביותר בהנתן "x

ובאופן פורמלי בחר α ( x ) = α kכך ש P ( wk | x ) -יהיה מקסימלי.

33

2.2.3שני מצבי עולם

הכרעה בייסיאנית אופטימלית

ראינו כי ההכרעה הבייסיאנית האופטימלית מתבצעת על ידי בחירת אסטרטגיית-

פעולה שהיא בעלת הסיכון המותנה הנמוך ביותר .במקרה שקיימים רק שני מצבי

עולם ,ושתי פעוות אפשריות ,אסטרטגיה זו מקבלת צורה פשוטה במיוחד .אם α i

היא הפעולה המתאימה למצב עולם ωiו λij -הוא המחיר שנשלם על הפעולה α i

במצב עולם , λij = λ (α i | ω j ) , ω jאז הסיכון המותנה בבחירת הפעולה α1הוא

) R (α1 | x ) = λ11 P(ω1 | x ) + λ12 P (ω 2 | x

והסיכון המותנה בבחירת הפעולה α2הוא

) R(α 2 | x ) = λ21 P(ω1 | x ) + λ22 P(ω 2 | x

ובגבול ההכרעה יהיו כל התצפיות שעבורן מתקיים שוויון בין הסיכונים,

) λ21 P (ω1 | x ) + λ22 P(ω 2 | x ) = λ11 P(ω1 | x ) + λ12 P(ω 2 | x

)(λ 21 − λ11 )P(ω1 | x) = (λ12 − λ 22 )P(ω 2 | x

כלומר כאשר

P (ω1 | x ) λ22 − λ12

=

P (ω 2 | x ) λ11 − λ21

)(2.3

נשתמש בנוסחת בייס ,נעביר אגפים ונקבל

P( x | ω1 ) P0 (ω 2 ) λ 22 − λ12

=

⋅

P( x | ω 2 ) P0 (ω1 ) λ11 − λ 21

אגף שמאל של המשוואה נקרא יחס הנראות ) ,(Likelihood ratioזהו היחס בין

הנראות של התצפית )ההסתברות לראות תצפית( במצב העולם הראשון לבין

הנראות במצב העולם השני .נוכל אם כן להגדיר סף :Θ

P0 (ω 2 ) λ 22 − λ12

,

⋅

P0 (ω1 ) λ11 − λ 21

=Θ

ולחלק באמצעותו את מרחב התצפיות לשני אזורים זרים :אזור בו יחס הנראות

גדול מהסף Θובו נכריע ω1ואזור בו יחס הנראות קטן מהסף Θובו נכריע . ω2

הגבול בין שני אזורים אלו יהיה כל התצפיות עבורן מתקיים

34

, P ( x | ω1 ) P ( x | ω 2 ) = Θוהוא נקרא גבול ההכרעה ).(Decision Boundary

המבחן שבו נשתמש יהיה אם כן להכריע ω1אם ורק אם

) P ( x | ω1

>Θ

) P( x | ω2

)(2.4

מקרה פרטי :פונקצית δכפונקצית מחיר

נטפל כעת במקרה בו פונקצית המחיר היא λ(αk,ωi)=1-δkjועלינו להכריע בין שני

מצבי העולם .הסיכון הכולל ] R[αבמקרה כזה הוא עבור משתנים מקריים בדידים

= ) Perror = ∑ min ( P (ω1 | xt ), P (ω 2 | xt ) ) P( xt

t

P ( xt | ω1 ) P (ω1 ) P ( xt | ω 2 ) P(ω 2 )

= ∑ min

,

) P ( xt

) P( xt

) P ( xt

t

) ) = ∑ min ( P ( xt | ω1 ) P (ω1 ), P( xt | ω 2 ) P (ω 2

t

מתקיים

בו

לאזור

מתחלק

התצפיות

מרחב

ושוב

) , P ( x | ω1 ) P (ω1 ) > P ( x | ω2 ) P(ω2ובו נכריע לטובת מצב העולם ,ω1ושאר

המרחב בו נכריע לטובת מצב העולם .ω2

דוגמא

עלי הכותרת של הפרח המצוי "לבלב מצוי" ניחנים באורך מופלג המתפלג באופן

אחיד בין סנטימטר אחד לבין 1.1סנטימטר.

10 1 ≤ x ≤ 1.1

P ( x | ω1 ) =

0 otherwise

עלי הכותרת של הזן הנדיר "לבלב נדיר" )הזהה לחלוטין לאחיו( הם בעלי נטייה

להיות ארוכים יותר ,על פי פונקצית ההתפלגות

20( x − 1) 1 ≤ x ≤ 1.1

P ( x | ω2 ) =

otherwise

0

קל לוודא כי פונקציות אלו הן התפלגויות והאינטגרל עליהם הוא אחד .מהו כלל

ההכרעה האופטימלי לאבחנה בין שני סוגי הלבלבים אם ידוע כי בדיוק 55אחוזים

מהלבלבים הפורחים במחוזותינו נמנים על פרח הלבלב המצוי ,והשאר הם לבלבים

"נדירים"?

35

נרצה למצוא כלל הכרעה כפונקציה של אורך העלים ,כך שלכל פרח שנמצא ,נוכל

להכריע בין שני מצבי העולם .נרצה להכריע "לבלב מצוי" אם )ורק אם( מתקיים

) . P(ω1 | x ) > P(ω 2 | xנרשום אם כן

) P( x | ω1 ) P0 (ω1

= )P (ω1 | x

=

) P ( x | ω1 ) P0 (ω1 ) + P ( x | ω2 ) P0 (ω2

10 ⋅ 0.55

5.5

=

10 ⋅ 0.55 + 20( x − 1) ⋅ 0.45 9 x − 3.5

9x − 9

= )P (ω2 | x) = 1 − P(ω2 | x

9 x − 3.5

=

הנקודות על גבול ההכרעה מקיימות ) , P (ω1 | x ) = P (ω 2 | xדהיינו

x = 1.611

⇒

5.5

9x − 9

=

9 x − 3.5 9 x − 3.5

ולכן נכריע לטובת הלבלב הנדיר אם ורק אם אורך עלי הכותרת יהיה גדול מ-

, 1.611כלומר אף פעם.

36

דוגמא :גבול הכרעה עבור שני מצבי עולם והתפלגויות נורמליות שוות

שונות

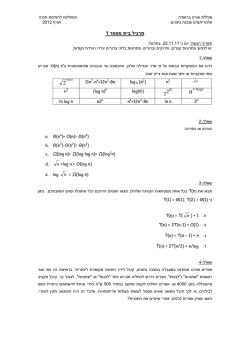

איור 2.1

גבול ההכרעה בין שתי התפלגויות נורמליות בעלות שונויות שוות הוא מפריד

לינארי .הדגמה עבור התפלגויות חד מימדיות ,דו מימדיות ותלת מימדיות.

37

דוגמא :גבול הכרעה עבור שני מצבי עולם והתפלגויות נורמליות דו

ממדיות

איור 2.2

גבולות ההכרעה בין שתי התפלגויות נורמליות בעלות שונויות שונות .במקרה החד

ממדי מתקבלים תחום שאינו רצוף .במקרה הדו ממדי גבולות ההכרעה הן

פונקציות ממעלה שניה )אליפסות ,היפרבולות(.

38

2.3בדיקת השערות פשוטות ומבחן סף

בסעיף הקודם תיארנו את הגישה הבייסיאנית לקבלת החלטות בתנאי אי ודאות.

על מנת להשלים את התמונה ,נתאר כעת בקצרה גישה סטטיסטית שונה לבדיקת

השערות.

2.3.1מושגים בבדיקת השערות

הגדרות

נניח כי אוסף מצבי העולם מתחלק לשתי קבוצות זרות אותן נסמן Ω0ו .Ω1 -נסמן

ב H0 -את ההשערה כי מצב העולם הוא בקבוצה Ω0וכן נסמן ב H1 -את ההשערה

כי מצב העולם הוא בקבוצה .Ω1כאשר Ω0מכילה רק מצב עולם יחיד ,אזי

ההשערה H0מכונה השערה פשוטה ) ,(Simple hypothesisבעוד שבמקרה בו

הקבוצה מכילה מספר מצבי עולם אפשריים היא מכונה השערה מורכבת

) .(composite hypothesisבאופן דומה מגדירים עבור H1ו. Ω1 -

עד כה התייחסנו להשערות H0ו H1 -באופן סימטרי ,אך בבעיות רבות נהוג

להתייחס אליהן באופן שונה .נהוג ש H0 -מסמלת את המצב השכיח )ברירת

המחדל( ומכונה השערת האפס ) ,(The null hypothesisבעוד H1מסמלת את

המצב הנדיר או המסוכן ומכונה ההשערה האלטרנטיבית (The alternative

).hypothesis

דוגמא:

נאמר שאנחנו רוצים לזהות האם בבדיקת משטח גרון ישנו זיהום חיידקי .ידוע כי

תוצאת ספירת החיידקים באדם בריא מתפלג נורמלית עם ממוצע 10ושונות ,20

ואילו באדם חולה הספירה מתפלגת נורמלית עם ממוצע בין 15ל 20 -ושונות .25

במקרה זה השערת האפס תהיה כי האדם בריא ,והיא השערה פשוטה ,בעוד

שההשערה האלטרנטיבית H1היא ההשערה שהאדם חולה והיא השערה מורכבת

היות והקבוצה Ω1מכילה קבוצה שלמה של מצבי עולם אפשריים ,לכל אחד מהם

תוחלת אחרת.

שני סוגי שגיאות

כאשר קיימות שתי קבוצות של מצבי עולם יש גם שני סוגים של שגיאות אפשריות.

שגיאה ראשונה ) (false positiveהיא המקרה בו נקבל בטעות את H1למרות

שמצב העולם הוא ב .Ω0 -במקרה של השגיאה השניה ) (false negativeנקבל

בטעות את .H0

39

2.3.2פרוצדורות הכרעה אופטימליות

פרוצדורת הכרעה להשערות פשוטות :משפט ניימן-פירסון

נתאר כעת פרוצדורת הכרעה אופטימלית כאשר שתי ההשערות הן פשוטות .תהי

δפרוצדורת הכרעה כלשהי ,אז נהוג לסמן את הסתברויות השגיאה באופן הבא:

) α (δ ) = Pr(Rejecting H 0 |Ω0

) β (δ ) = Pr(Accepting H 0 |Ω1

)(2.5

השגיאה αנקראת גם המובהקות של המבחן ,ו (1-β) -נקראת עוצמת המבחן.

בבואנו להגדיר פרוצדורה להכרעה בין שתי השערות נרצה להביא למינימום את

השגיאות αו .β -נוכל כמובן לקבוע מבחן שמכריע תמיד ,H0ובכך להביא את

השגיאה αלאפס ,אך במקרה כזה השגיאה βתהיה אחת .קריטריון שנראה סביר

הוא לנסות ולהביא למינימום קומבינציה לינארית של השגיאות מהצורה

) . aα (δ ) + bβ (δעבור קריטריון כזה קיימת פרוצדורת הכרעה שהיא אופטימלית

במובן הבא :לכל בחירת ערך של αהפרוצדורה מביאה למינימום את .β

הפרוצדורה המבוקשת מתוארת על ידי הלמה של ניימן-פירסון ):(1933

יהי Θ>0ו δ* -פרוצדורת הכרעה בעלת המבנה הבא :ההשערה H0

מתקבלת אם ) f 0 ( x ) > Θf1 ( xואילו ההשערה H1מתקבלת אם

) ) f 0 ( x ) < Θf1 ( xכאשר fiהיא ההסתברות לקבל התצפית xבהנחת

.(Hiאז לכל פרוצדורת הכרעה אחרת ,δהמקיימת

)* α (δ ) ≤ α (δמתקיים )* , β (δ ) ≥ β (δואם )* α (δ ) < α (δאז

)* . β (δ ) > β (δ

למרות פשטות ההוכחה לא נוכיח את הלמה כאן מטעמי קיצור .המסקנה ממשפט

זה היא שלכל רמת מובהקות ,αמבחן יחס נראות מהצורה

) f1 ( x

)(2.6

>Θ

)f0 ( x

משיג עוצמה מקסימלית )דהיינו שגיאת βמינימלית( .בסעיף הקודם הגענו

למסקנה דומה לגבי מבחן יחס נראות כאשר נקטנו בגישה בייסיאנית ,אבל כאן לא

נדרשנו להניח כי ידועות לנו ההתפלגויות האפריוריות של מצבי העולם ,אלא קיבלנו

כי מבחן יחס נראות הוא אופטימלי במקרה של הכרעה בין שתי השערות פשוטות.

השערות מורכבות

כאשר עוברים לטפל בהשערות מורכבות ,דהיינו להכריע בין קבוצות אפשריות של

מצבי עולם ,הסתברויות השגיאה αו ,β -אינן מוגדרות היטב ויש להגדירן כראוי.

פתרון בגישה הבייסיאנית יהיה להביט על השגיאות הממוצעות מסוג αו,β -

)למשל αתהיה הסיכוי לדחות את H0באופן ממוצע על פני מצבי העולם ב,( Ω0 -

40

אך גישה זו דורשת לדעת את ההסתברויות האפריוריות לכל אחד ממצבי העולם

ב . Ω0 -הגישה הסטטיסטית המקובלת נמנעת מלהגדיר הסתברויות אפריוריות

כאלו ,ובמקום זה מגדירה

(2.7) α = sup ( Pr(Reject H 0 | ω ) ) ,

ω ∈ Ω0

דהיינו ניקח את המקרה הגרוע ביותר מבין כל מצבי העולם בקבוצה .Ω0במקרה

זה לא קיים משפט מקביל ללמה של ניימן-פירסון ולא קיים מבחן שמבטיח עוצמה

מקסימלית לכל מצב עולם .;ω0ניתן עם זאת להגדיר פרוצדורה דומה של יחס

נראות המקיימת תכונות מועילות אחרות שלא נכנס אליהן כאן.

2.4תצפיות מרובות ומבחן סדרתי

2.4.1שימוש בתצפיות מרובות

עד כה התמקדנו במקרה בו נתונה לנו תצפית בודדת ,xוראינו כלל הכרעה

אופטימלי מהצורה

) P ( x1 | ω1

> Θ.

) P ( x1 | ω 2

אך למעשה כל הניתוח שלנו מתאים גם למקרה בו נתונות לנו תצפיות מרובות,

שאז נשתמש בכלל הכרעה מהצורה

) P ( x1 ,..., xn | ω1

>Θ,

) P ( x1 ,..., xn | ω 2

וכפי שראינו ,עבור בחירה נכונה של הסף ,כלל הכרעה זו הוא אופטימלי במובן של

מינימום סיכון .פעמים רבות ,התצפיות שלנו נאספות על ידי חזרות מרובות על

אותו ניסוי .במקרה כזה )ואם הניסוי נערך כהלכה( ,לכל התצפיות ישנה אותה

התפלגות והן בלתי תלויות .במקרה זה המשתנים המקריים המתאימים הם שווי

התפלגות ובלתי תלויים זה בזה בהנתן מצב העולם ,כך שכלל ההכרעה עבור

תצפיות מרובות מקבל את הצורה

n

) P( xi | ω1

>Θ.

∏

) i =1 P ( xi | ω 2

2.4.2בחינת תצפיות מרובות באופן סדרתי

הניתוח לעיל מתאים למקרה בו כל התצפיות ניתנות "בבת אחת" .קיימים מקרים

רבים בהם התצפיות נאספות בזו אחר זו ויש לנו אפשרות לנסות ולהכריע במהלך

איסוף התצפיות .בעיות מסוג זה נקראות בעיות למידת ) on-lineבניגוד למקרה בו

כל הדגימות נתונות מראש הנקרא למידת .(batchנפנה כעת לנתח את התפתחות

הציונים שתיארנו עבור תצפיות הניתנות בזו אחר זו .כפי שראינו ,עבור תצפית

בודדת מתקיים

41

) P ( x1 | ω

) P (ω , x1

⋅ ) = P0 (ω

) P( x1

) P0 (ω ) P ( x1

הסתכלות אפשרית על נוסחה זו היא כי ההסתברות האפריורית למצב העולם

) P0 (ωמוכפלת ב" -גורם תיקון" ]) , P (ω , x1 ) [ P0 (ω ) P( x1וכאשר גורם תיקון זה

שונה מאחד ,כלומר כאשר ) , P ( x1 , ω ) ≠ P0 (ω ) P ( x1המדידה מספקת אינפורמציה

על מצב העולם.

⋅ ) P (ω | x1 ) = P0 (ω

אם יש לנו שתי מדידות x1 , x2 ,אזי ההסתברות למצב העולם לאור שתי התצפיות

תהיה

= ) P (ω | x1 , x2

) P0 (ω ) P ( x1 , x2 | ω

) P0 ( x1 , x2

) P ( x1 | ω ) P ( x2 | ω , x1

⋅

) P ( x1

) P ( x2 | x1

=

) = P0 (ω

וגורמי התיקון כאן הולכים ומסתבכים.

במקרה בו התצפיות בלתי-תלויות בהינתן

) , P ( x1 , x2 | ω ) = P ( x1 | ω ) P( x2 | ωאז ניתן לרשום

) P ( x1 ,..., xn | ωi

) P ( x1 ,..., xn

מצב

) P (ωi | x1 ,..., xn ) = P0 (ωi

) P ( x1 ,..., xn | ωi

) | ω j )P0 (ω j

m

n

העולם,

∑ P( x ,..., x

1

) = P0 (ωi

j =1

1

) P( x1 ,..., xn | ω j ) P0 (ω j

) | ωi ) P0 (ωi

n

m

∑ P( x ,..., x

j =1

1

1

) P( x1 ,..., xn | ω j ) P0 (ω j

) P ( x1 ,..., xn | ωi ) P0 (ωi

=

m

∑ 1+

j ≠i

=

דהיינו

42

ובמקרה שקיימים רק שני מצבי עולם נקבל

1

) P ( x1 ,..., xn | ω 2 ) P0 (ω 2

1+

) P( x1 ,..., xn | ω1 ) P0 (ω1

= ) P (ω1 | x1 ,..., xn

1

) P0 (ω 2

) n P ( xi | ω 2

∏

i =1

) P0 (ω1

) P ( xi | ω1

=

1+

1

P( xi | ω 2 )

P0 (ω 2 )

1 + exp ∑ log

+ log

P ( xi | ω1 )

P0 (ω1 )

i =1

n

)(2.8

=

וקיבלנו פונקציה סיגמואידית שהשיפוע שלה גדל עם , nכלומר ,היכולת להבחין בין

שני מצבי העולם גדלה וההסתברויות נעשות חדות עם הגידול במספר התצפיות.

כאשר nגדול ,ההסתברות למצב עולם בהנתן התצפיות היא או אפס ,או אחת.

2.4.3מבחן סדרתי להכרעה -

Sequential Probability Ratio Test

)(SPRT

נשוב לבעיית ההכרעה הבייסיאנית .בפרק הקודם תיארנו פרוצדורה להכרעה בין

שני מצבי עולם בה השווינו את יחס הנראות לסף .כעת ,כאשר אנחנו פועלים

בתרחיש של למידת ,on-lineיש לפנינו שלוש אפשרויות במקום שתיים :בנוסף

לשתי ההכרעות )לקבל מצב עולם 1או לקבל מצב עולם (0אנחנו יכולים ל"החליט

שלא להחליט" ,ולדרוש נתונים נוספים לצורך הכרעה .מסתבר כי בדומה למבחן

ההשוואה לסף אותו תיארנו בפרק הקודם ,ניתן לבחור ספים עבור פרוצדורה מסוג

זה כך שיובטחו הסתברויות השגיאה הנדרשות .נעבור אם כן לתיאור פורמלי של

פרוצדורת ההכרעה מסוג זה.

משפט (Wald 1942) :בהנתן 1 ≥ α , β ≥ 0נגדיר מבחן "סדרתי" המשתמש בשני

ספים

ω1

continue

ω0

)

)

(

(

)(n

1 − α L x | ω0

<

n

β

L x ( ) | ω1

n

L x ( ) | ω0

1−α

α

<

<

decision =

)n

(

β

1 − β L x | ω1

n

L x ( ) | ω0

α

<

)(n

1− β

L x | ω1

)

)

)

)

(

(

(

(

)(2.9

43

אם נסמן ב α ' -את הסתברות השגיאה מסוג ראשון של מבחן זה ,ןב β ' -את

β

α

≤ ' αו-

הסתברות השגיאה מסוג שני ,אזי מובטח כי

1− β

1−α

≤' .β

מבחן זה מכריע מצב עולם 1אם חוצים את הסף העליון ,מצב עולם 0אם יורדים

מתחת לסף התחתון ,ובמקרה שערכו של יחס הנראות הוא בין שני הספים ,יש

לחכות לתצפיות נוספות .בפועל ,פרט לאי דיוק הנובע מכך דגימות הן אלמנטים

בדידים ,מתקיים α ' ≤ αו. β ' ≤ β -

הוכחה:

יהיו Aו B -שני ספים )מאוחר יותר נגדיר את הערכים שלהם במפורש ,ולעת עתה

יהיו מספרים כלשהם( ,ובאמצעותם נגדיר את קבוצת סדרות התצפיות באורך n

שעבורן אנחנו מכריעים ω1בדיוק כשהגענו לתצפית ה -n -ית

Cn = {x (n) such that decide ω 1

}exactly after n observations

(

(

)

)

l

L x ( ) | ω0

) (n

≤ = x such that B

= ≤ A for l

l

L x ( ) | ω1

(

) < B

) L ( x( ) | ω

L x ( ) | ω0

)(2.10

n

n

1..n − 1 and

1

ובאופן דומה את קבוצת הסדרות באורך nעבורן נכריע ω0בתצפית ה-n -ית

Dn ≡ {x (n) such that decide ω0

}exactly after n observations

(

)

(

)

L ( x ( ) | ω )

< 1..n − 1 and A

L ( x( ) | ω )

l

L x ( ) | ω0

) (n

≤ = x such that B

= ≤ A for l

l

L x ( ) | ω1

)(2.11

n

0

n

1

המאורע בו נכריע ω1הוא איחוד המאורעות } ,{Cnשהם מאורעות זרים וממצים.

לכן ,הסיכוי הכולל שנכריע ω1הוא פשוט סכום הסיכויים שנכריע ω1בכל צעד ,n

כלומר

∞

) P ( decide ω1 ) = ∑ P ( Cn

n =1

44

והסתברות השגיאה מסוג ראשון αנתונה על ידי:

)

וכן

(

(2.12) α = ∑ P ( Cn | ω0 ) = ∑ ∫ Pr X ( ) | ω 0

n

Cn

n

n

= ) 1 − β = 1 − ( probability to decide ω0 while ω1

= ) = ( probability to decide ω1 while ω1

)

ובאופן דומה

n

0

1 − α = ∑ ∫ Pr X

Dn

כעת לכל סדרה

)

(

)

| ω 0 ≤ B ⋅ Pr X ( ) | ω1

n

)

)(n

(

n

n

1

( x1 ,..., xn ) ∈ Cn

n Cn

) ( |ω

) β = ∑ ∫ Pr ( X ( ) | ω

)(n

.

(

= ∑ ∫ Pr X ( ) | ω1

Dn

)(2.13

n

)הכרענו ω1אחרי nתצפיות בדיוק( מתקיים

, Pr xולכן

(

(

)

α = ∑ ∫ Pr x ( n ) | ω 0 ≤ ∑ ∫ B ⋅ Pr X ( n ) | ω1

Cn

n

Cn

n

) = B (1 − β

ולכל סדרה ב Dn -מתקיים

)

| ω1

)(n

) ∑ ∫ A ⋅ Pr (X

≥ | ω0

n Dn

)( n

∑ ∫ Pr (X

= 1−α

n Dn

= A⋅ β

כלומר מצאנו חסמים על הסתברויות השגיאה במונחים של ערכי הסף Aו.B-

המסקנה מניתוח זה היא שבהנתן ערכי שגיאות α0ו β0 -רצויים נוכל לקבוע ספים

' Aו , B' -התלויים רק ב α0 -וβ0 -

α0

1 − β0

1− α0

≡ 'A

β0

≡ 'B

)(2.14

וספים אלו מקיימים B ' ≤ Bו . A' ≥ A -ולכן מבטיחים כי אם נעבור אותם – נעבור

גם את Aו B-והסתברויות השגיאה בפועל של המבחן יקיימו ) α ' ≤ α 0 /(1 − β 0ו-

45

) . β ' ≤ β 0 /(1 − α 0האיור המצורף להלן מבהיר את היחס בין ספים אלו .כאמור

ניתן גם להראות כי בפועל ,פרט לאי דיוק הנובע מכך שהדגימות הן אלמנטים

בדידים ,מתקיים α ' ≤ αו . β ' ≤ β -כפי שכבר ציינו ,בדרך כלל נשתמש במבחן

לוג יחס הנראות במקום ביחס הנראות ,ולכן גם בלוג של הספים.

דוגמא

בתכנון ערכה לזיהוי תאים סרטניים נרצה הסתברות גילוי של ( α = 10−4 ) 99.99%

והסתברות התראות שווא של , ( β = 10−3 ) 0.1%ונקבל את הספים הבאים

המבטיחים שלא נחרוג מהסתברויות השגיאה הנדרשות

1 − α 0.9999

=

≅ 1000 ⇒ log10 ( A) = 3

=A

β

10−3

α

10−4

=B

=

≅ 10−4 ⇒ log10 ( B ) = −4

1 − β 0.999

כמות התצפיות הדרושות לקבלת הכרעה

המבחן הסדרתי מאפשר לנו להגיע להכרעה עם מספר תצפיות שמשתנה באופן

גמיש :אם בשל מזל טוב במיוחד התצפיות הראשונות שקיבלנו הן כאלו שעבורן קל

להכריע ,הרי שנסתפק בהן .אם לעומת זאת נקבל תצפיות שאינו מאפשרות

הכרעה ,הרי שנצטרך להשתמש ביותר תצפיות .מסתבר ,שבאופן ממוצע

פרוצדורת המבחן הסדרתי דורשת שימוש בפחות תצפיות מאשר כמות התצפיות

הדרושה במבחן יחס נראות שאיננו סדרתי .לכן פרוצדורה כזו היא שימושית

במיוחד במקרה שיש עלות גבוהה לייצר דגימה )למשל כאשר כל אחת מהתצפיות

דורשת לבצע ניסוי ארוך/יקר/מסוכן על נבדקים מתנדבים( .למעשה ,התיאוריה

אותה אנו מתארים פותחה לראשונה על ידי Waldלצורך בדיקת איכות של סדרות

פגזים במלחמת העולם השניה :בהינתן סדרת ייצור של פגזים ,היה צורך לבצע

ניסויי ירי ולהכריע האם הסדרה תקינה או פגומה .השאיפה להכריע לגבי תקינות

הסדרה על ידי שימוש בכמה שפחות פגזים ,הביאה את הצי האמריקאי לפנות

לסטטיסטיקאים שיפתחו פרוצדורות יעילות לבחינת הפגזים.

46

כדי להעריך כמה תצפיות בממוצע דרושות על מנת לקבל הכרעה ,נתבונן כיצד

(

מתנהג )

logכפונקציה של .nכאשר הדגימות הן בלתי תלויות בהנתן

) (

) L ( X ,ω

מצב העולם ,אז ) , P ( X ( ) | ω ) = ∏ P ( X | ωונרשום

L X ( ) ,ω0

n

n

1

n

i

n

i =1

P0 (ω0 ) n P ( X i | ω0 )

y ≡ log

=

∏

P0 (ω1 ) i =1 P ( X i | ω1 )

n

) ) = log ( P0 (ω0 ) ) + ∑ log ( P ( xi | ω0

i =1

n

= ) ) − log ( P0 (ω1 ) ) − ∑ log ( P ( xi | ω1

i =1

P0 (ω0 ) n

P ( xi | ω0 )

= log

+ ∑ log

=

P

ω

P

x

|

ω

(

)

(

)

=

1

i

0

1

1

i

1 n

P0 (ω0 )

P ( xi | ω0 )

= log

+ n ∑ log

≡

P0 (ω1 )

P ( xi | ω1 )

n i =1

≡a⋅n+b

כלומר קבלנו משוואה לינארית מהצורה y = a·n + bכשהשיפוע

P ( xi | ω 0 )

1 n

log

∑

n i =1

P ( xi | ω1 )

=a

)(2.15

הוא הממוצע האמפירי של לוג יחס הנראות .על-פי החוק החלש של המספרים

הגדולים ,ממוצע של nמשתנים מקריים המתפלגים i.i.d.שואף לתוחלת

1 n

) . ∑ i =1 xi → ∑ { x} x ⋅ p ( xההסתברות לפיה נחשב את התוחלת תלויה במצב

n

העולם האמיתי ,ולכן נקבל במצב ω0

P ( xi | ω 0 )

1 n

lim ∑ log

n →∞ n

i =1

P ( xi | ω1 )

)(2.16

P ( x ' | ω0 )

→ ∑ P ( x ' | ω 0 ) log

'x

P ( x ' | ω1 )

47

ובמצב ,ω1שוב על פי חוק המספרים הגדולים

P ( xi | ω1 )

1 n

log

∑

n →∞ n

i =1

P ( xi | ω12 )

lim

P ( x ' | ω0 )

(2.17) → ∑ P ( x ' | ω1 ) log

=

'x

P ( x ' | ω1 )

P ( x ' | ω1 )

= − ∑ P ( x ' | ω1 ) log

'x

P ( x ' | ω0 )

הביטויים שקיבלנו מכילים תלויות במדד חשוב לדמיון בין התפלגויות שאותו נתאר

בסעיף הבא.

2.4.4מדד לדמיון בין התפלגויות

–

The Kullback Leibler

Divergence

הגדרה :המרחק הסטטיסטי

עבור Xמ"מ בדיד ו ,P -ו Q -שתי התפלגויות ,הגודל

p( x )

D [ p || q ] = ∑ p( x )log

x

q( x )

)(2.18

מהווה מדד למידת הדמיון הסטטיסטי בין ההתפלגויות .לגודל מספר רב של שמות:

, Kullback Leibler Divergence, Relative Entropy, Cross Entropyוחשיבותו

רבה בתורת האינפורמציה ,בלמידה חישובית ובפיסיקה סטטיסטית .למרבה

הבלבול ,תחומי מדע שונים נוהגים לבחור בסיס שונה לפונקצית הלוג במשוואה:

בפיסיקה נהוג השימוש בלוגריתם הטבעי ובמדעי המחשב בלוג בבסיס .2אנחנו

נשתמש בבסיסים שונים לפי הצורך ,ונשים לב כי שינוי בסיס הלוגריתם מתבטא

בהכפלת המרחק בקבוע.

מדד זה אינו עונה לקריטריונים של מרחק היות והוא אינו סימטרי ואינו מקיים את

אי שוויון המשולש .קל להבין את הסיבה לחוסר הסימטריה אם נזכר כי הראנו ש-

Dמודד עד כמה קל להבחין בין שתי התפלגויות הנובעות משני מצבי עולם .היות

והתצפיות שאנו רואים בפועל תלויות במצב העולם ,אז יתכן שאחד ממצבי העולם

יספק תצפיות שיקלו על ההכרעה.

למרות שאינו עונה על הקריטריונים של מרחק ,המדד Dמקיים תכונות חשובות

ההופכות אותו לשימושי להשוואת התפלגויות .נראה כעת שלוש תכונות כאלו:

נראה כי הוא מדד חיובי ,וכן את הקשר שלו לשני מדדי מרחק אחרים.

48

טענה D[p||q] :הוא אי שלילי ,ומקבל ערך אפס אם ורק אם p=qכמעט

בכל מקום

הוכחה

נסמן ב A -את קבוצת המאורעות שעבורם . A = {x : p( x ) > 0} , p(x)>0נשתמש

באי השוויון ) log( x ) ≤ x − 1עבור הבסיס הטבעי( ,ונרשום

p( x)

p( x) log

=

q ( x)

x∈ A

− D [ p || q ] = −

q ( x)

p ( x) log

≤

p( x)

x∈ A

=

) q( x

p ( x)

= − 1

p ( x)

x∈ A

=

∑

∑

∑

≤ )p ( x

∑

p ( x) = 1 − 1 = 0

∑

q( x) −

∑

q( x) −

∑

x∈ A

)(2.19

=

x∈ A

x∈ A

=

x∈Ω

נשים לב כי על מנת שיתקיים שוויון ,דרוש כי לכל xב A -מתקיים

) ) , log ( q ( x) / p ( x) ) = 1 − ( q( x) / p( xושוויון זה מתקיים אם ורק אם ). p(x)=q(x

קיבלנו כי D [ p || q ] = 0אם ורק אם ) p(x)=q(xלכל xשעבורו .p(x)>0

טענה D(p||q) :מקיים

2

1

≥ ] D [ p || q

p ( x ) − q( x )

∑

2ln 2 x

כאשר Dמחושב עם לוג בבסיס .2הוכחה בתרגיל.

טענה D[p||q] :חסום על ידי

1

( p( x ) − q( x )) 2

1

( p( x ) − q( x ))2

≤

≤

D

[

p

||

q

]

∑

∑

)) 2 x max( p( x ), q( x

)) 2 x min( p( x ), q( x

)(2.21

)(2.20

49

טענה:

כאשר , p ≈ qניתן לקרב את ] D[p||qעל ידי

1

) 1 n ( pi − qi

=

χ p ,q 2

∑

pi

2ln 2 i =1

2 ln 2

2

≈ ] D [ p || q

)(2.22

ומכאן שניתן לקרב את Dעל ידי מדד , χ 2שהוא מדד נפוץ בסטטיסטיקה קלאסית

להשוואה בין התפלגויות .ההוכחה בתרגיל.

טענה D(p||q) :מקיים את כלל השרשרת הבא:

]) D [ p( x, y ) || q( x, y

]) = D [ p( x ) || q( x )] + D [ p( y | x ) || q( y | x

)(2.23

הוכחה

p( x, y )

D [ p( x, y ) || q( x, y )] = ∑∑ p( x, y ) log

=

x

y

q( x , y )

p( x ) p( y | x )

= ∑∑ p( x, y )log

=

x

y

q( x ) q( y | x )

p( x )

p( y | x )

= ∑∑ p( x, y )log

+ ∑∑ p( x, y )log

=

x

y

q( x ) x y

q( y | x )

]) = D [ p( x ) || q( x )] + D [ p( y | x ) || q( y | x

שימוש במרחק סטטיסטי להערכת סבירות של תוצאות

נניח שאנחנו מבצעים nניסויי ברנולי שלכל אחד הסתברות pלהצלחה .מהו הסיכוי

לקבל mהצלחות?

מספר ההצלחות מתפלג בינומית

n

!n

= Pn ( m ) = p m (1 − p ) n −m

p m (1 − p )n − m

m

(!

−

!)

m

n

m

נשתמש בנוסחת סטירלינג לקירוב העצרת

1

) 2π n ⇒ log ( n !) ≈ n log ( n ) − n + log ( 2π n

2

n

n

n! ≈

e

50

ואם נזניח את האיבר השלישי ,נוכל לרשום

n

!n

log = log

m

m!(n − m)!

] )≈ [ n log n − n ] − [ m log m − m] − [ (n − m)log(n − m) − ( n − m

m

n−m

= n log( n) − log(m) −

log(n − m)

n

n

m

m n−m

n − m

log

= n − log −

n

n

n

n

m

ואם נסמן ב qm / n -את התפלגות ברנולי עם סיכוי

n

m

m n−m

n−m

log ( Pn ( m ) ) ≈ n − log −

log

+

n

n

n

n

להצלחה ,אז קיבלנו

)(n − m

m

log ( p ) +

log (1 − p )

n

n

] = − nD [ qm / n || p

+

או

)] Pn ( m ) ≈ exp ( − nD[ qm / n || p

)הערה :אם נחשב את Dלפי בסיס שתיים אז נקבל "שתיים בחזקת…" במקום

האקספוננט(.

הקירוב שקיבלנו יכול לשמש אותנו לא רק להערכת ההסתברות לקבל תוצאה

מסוימת ) mהצלחות( אלא אף לצורך הערכת הסתברות הזנב כולו ) mהצלחות או

יותר( ,בדומה לחסם צ'רנוף .לא נוכיח טענה זו כאן בפירוט ,אך ניתן סקיצה של

ההוכחה .על מנת לחסום את הסתברות הזנב )דהיינו סכום של ) (n-mאיברים

אקספוננציאלים( ,נשים לב כי האיבר הגדול ביותר בסכום הוא האיבר הראשון

) ,Pn(mוישנם n-mאיברים בסכום .לכן הסכום כולו קטן מביטוי מהצורה

n exp ( − nD [ qm / n || p ]) = exp ( − nD [ qm / n || p ] + ln( n ) ) .

וקיבלנו חסם שעבור nגדול יורד אקספוננציאלית עם גודל המדגם nבדומה לחסם

צ'רנוף.

51

לצורך ההמחשה ,נציג דוגמא מספרית .נחסום את ההסתברות לקבל 70פעמים

"עץ" מתוך 100הטלות של מטבע מאוזנת .נציב p=0.5ונקבל

0.7

0.3

D [0.7,0.3 || 0.5,0.5] = 0.7log

+ 0.3log

= 0.083 .

0.5

0.5

מכאן שההסתברות לקבל 70פעמים "עץ" מתוך 100הטלות כאשר המטבע

מאוזנת ,חסומה על ידי

P100 ( 70 | .5,.5) ≤ exp [ −100 ∗ .083] = exp( −8.3) = 0.00025

דוגמא :מרחק בין התפלגויות נורמליות

נניח שיש לנו שני מצבי עולם ,אחד בו התצפיות מגיעות מהתפלגות נורמלית

המאופיינת ע"י תוחלת µ1וסטית תקן , σ 1והשני בו התצפיות מפולגות נורמלית

עם תוחלת µ2וסטית תקן σ 2

,

( x − µ1 ) 2

1

exp −

2

2σ 1

2πσ 1

= ) f1 ( x

( x − µ2 ) 2

exp −

= ) f2 ( x

2

2σ 2

2πσ 2

1

נחשב את המרחק הסטטיסטי בין ההתפלגויות .באפן טבעי ,מרחק הסטטיסטי

עבור משתנים רציפים מוגדר כאינטגרל על פונקצית צפיפות ההתפלגות במקום

סכום על פונקצית ההסתברות .נשתמש בביטויים עבור תוחלת ושונות של משתנים

2

נורמליים , E ( x − µ1 ) 2 = σ 1 , E [ x ] = µ1 :ונרשום

] D [ P1 || P2

∞

P1 ( x )

= ∫ P ( x ) log P ( x ) dx

1

2

= dx

dx

( x − µ1 ) 2

−

2σ 12

∞−

σ 2 − ( x − µ1 ) + ( x − µ2 ) exp

2σ 12

2σ 22

2πσ 1

1

2

2

( x − µ2 + µ1 − µ1 )2

2σ 22

⋅

− ( x − µ1 ) 2

2

2σ 1

∞

∫ log σ

∞

− σ + exp

∫ 2πσ 1

2σ

∞−

2

1

2

1

=

=

∞−

σ

* = log 2

σ1

σ

] 1 E [ ( x − µ1 )2 + 2( x − µ1 )( µ1 − µ2 ) + ( µ2 − µ1 ) 2

= log 2 − +

2σ 22

σ1 2

2

σ

1 1 σ 12

) (µ − µ

+0+ 2 21

* = log 2 − +

2

2σ 2

σ1 2 2 σ 2

52

בשוויונים המסומנים בכוכבית השתמשנו בעובדה שתחת ההתפלגות ,P1ל-

) ( x − µ1יש שונות σ 12ולכן

( x − µ1 )2

= σ 12 .

2σ 12

−

∫(x − µ ) e

2

1

) (2πσ

2 −1/ 2

1

במקרה הכללי ,המרחק שקיבלנו איננו סימטרי כמובן ,אך במקרה המיוחד בו

השונויות זהות σ 1 = σ 2נקבל כי האיברים הראשונים מתבטלים ונשאר עם

2

) ( µ2 − µ1

2σ 2

= ] D [ P1 || P2

)(2.24

כלומר Dמבטא במקרה זה את ריבוע המרחק בין התוחלות ביחידות של סטית

תקן )"סיגמאות"( .מרחק זה נקרא גם "מרחק מהאלאנוביס" ),(Mahalanobis

והשורש הריבועי שלו ידוע גם בתור "יחס אות לרעש" ),(Signal-to-Noise Ratio

והוא מדד נפוץ למדידת יכולת ההבחנה בין הערכים אפשריים של משתנה מקרי

רציף המקבל שני ערכים שעליהם נוסף רעש.

53

תרגילים

.1נניח כי אנו מחליפים את פונקצית ההכרעה הדטרמניסטית α ( x ) ,בכלל

הכרעה אקראי :בהינתן התצפית xאנו מבצעים את הפעולה αiבהסתברות

) P (αi | xi

א .הראו

הכולל

הסיכון

כי

R = ∫ ∑ R (αi | x ) ⋅ P (α i | x ) P ( x ) dx

i

במקום האינטגרל(.

כעת

נתון

על-ידי

)במקרה בדיד מופיע סכום

ב .הראו כי Rהינו מינימאלי אם אנו בוחרים P (αi | xi ) = 1עבור הפעולה αi

המביאה למינימום את הסיכון המותנה,

דטרמיניסטית היא אופטימלית.

) , R (α i | xולכן הכרעה

.2נניח שמציעים לכם להשתתף במשחק הבא :מטילים זוג קוביות הוגנות עד

שיוצא " "1לפחות באחת מהקוביות .לפני כל הטלה אתם יכולים להחליט אם

אתם ממשיכים להשתתף במשחק או יוצאים ממנו .אם אתם ממשיכים

להשתתף במשחק אתם זוכים בשקלים עפ"י תוצאת ההטלה )סכום התוצאות

בשתי הקוביות( למעט המקרה שבו יוצא " "1לפחות באחת מהקוביות שבו

אתם מפסידים את כל מה שהרווחתם .אם הספקתם לצאת מהמשחק לפני

שיצאה התוצאה " "1אתם נשארים עם מה שהרווחתם עד כה.

א .נסחו את הבעיה כבעיית הכרעה בייסיאנית.

ב .מהי האסטרטגיה הבייסיאנית האופטימאלית לקבלת החלטה אם להמשיך

לשחק או לצאת מהמשחק?

ג .מהו הסכום המרבי שתהיו מוכנים לשלם כדי להשתתף במשחק? נמקו.

.3יהיו s1ו s2 -שני "מקורות" פואסוניים ,עם λ1ו λ2 -בהתאמה.

א .בהנתן סדרת דגימות מאחד המקורות ,כמה דגימות נחוצות על מנת

להכריע מהו מקור הסדרה בוודאות של 99אחוזים )לכל כיוון(.

ב .תאר גישה בייסיאנית לטיפול במקרה בו נוסף מקור שלישי עם . λ3מה

יהיה כלל ההכרעה במקרה זה?

.4גבול הכרעה בין התפלגויות נורמליות.

א .נתונה בעיית ההכרעה הבאה X :מתפלג נורמלית )חד ממדית( עם

) . P ( x | w2 ) = N ( µ2 ,σ 22 ) , P ( x | w1 ) = N ( µ1 ,σ 12מהו גבול ההכרעה

בהנחה כי ההסתברויות

) ) ? ( P ( w1 ) = P ( w2

ב.

האפריוריות

לשני

מצבי

מתפלג

X

אם

ההכרעה

גבול

מהו

2

) . P ( X | w2 ) = N X ( µ2 , ∑ 2 ) P ( X | w1 ) = N X ( µ1 , ∑12

העולם

שוות

דו-נורמלית

עם

54

ג .מצא את הגבול במקרה הפרטי בו מטריצות הקווריאנס הן אלכסוניות ושוות

המחירים

ומטריצת

שוות

האפריוריות

ההסתברויות

וכן

מקיימת λ11 = λ22 = 0ו. λ12 = λ21 -

.5יהיו x1 , x2 ,..., xnמשתנים-מקריים המתפלגים באופן אחיד בקטע ] [0,1נגדיר

n

) Vn = ∏ xiכלומר נפח התיבה ה n -ממדית ש x1 ,..., xn -הן צלעותיה(.

i=1

1

n

א .מהו ? lim Vn

∞→ n

ב .השוו גודל זה לשורש הn -י של הנפח "הנאיבי" ,המתקבל ממכפלת

האורכים הממוצעים של הצלעות) ,כלומר

1

2

=

) (

1/ n

1n

2

(.

.6הוכיחו כי ה"מרחק" Dבין שתי התפלגויות ברנולי עם סיכויי הצלחה pוq -

מקיים

2

2

≥ ] D [ p || q

)( p − q

ln 2

הדרכה :הגדירו פונקציה ) g(p,qשהיא ההפרש בין שני האגפים

2

2

g ( p, q ) = D [ p || q ] −

)( p − q

ln 2

הראו כי הנגזרת של פונקציה זאת קטנה או שווה לאפס כאשר q ≤ pוהסיקו

מכך כי g ( p, q ) ≥ 0עבור . q ≤ p

.7הוכח כי המרחק Dחסום על ידי

1

( p( x ) − q( x )) 2

1

( p ( x ) − q( x ))2

∑ ≤ ] ≤ D[ p || q

∑

)) 2 x max( p ( x ), q( x

)) 2 x min( p ( x ), q( x

.8הוכח כי כאשר , p ≈ qניתן לקרב את ] D[p||qעל ידי

1

) 1 n ( pi − qi

≈ ] D [ p || q

=

χ p ,q 2

∑

2ln 2 i =1

pi

2 ln 2

2

.9חשב את המרחק הסטטיסטי בין שתי התפלגויות פואסוניות.

.10חשב את המרחק הסטטיסטי בין שתי התפלגויות אקספוננציאליות.

55

תרגיל מחשב

כתבו תכנית להכרעה סדרתית בין טקסט הכתוב באנגלית לטקסט כתוב בצרפתית,

על סמך פילוגי האותיות הבודדות בשתי השפות )כולל רווח( .הקלט לתכנית יהיה

הפילוגים ,טקסט ארוך והסתברויות השגיאה מסוג ראשון ושני ) . (α , β

א .צייר גרף של הציון המצטבר )לוג הנראות( כפונקציה של אורך הטקסט .סמן

את החסמים )'.(A', B

ב .מהו אורך הטקסט הנדרש להכרעה ומהן תוצאות המבחן.

ג .צור גרפים של אורך הטקסט כפונקציה של αעבור βקבוע ולהיפך.

ד .השוו את התוצאה המתקבלת לאורך הצפוי על-פי המרחק הסטטיסטי בין

הפילוגים.

ה .מצאו טקסט בשפה )לטינית( שלישית ,וחזרו על החישובים מהסעיפים

הקודמים עבור השפה החדשה עם אחת משתי השפות הקודמות.

56

© Copyright 2026